Intern 快速 Landing+环境搭建

Intern 快速 Landing+环境搭建 item2下载 Mac 终端工具 https://iterm2.com/downloads.html homebrew下载 Mac 软件包管理工具 https://brew.sh/ brew换国内源: 12345export HOMEBREW_INSTALL_FROM_API=1export HOMEBREW_API_DOMAIN="https://mirrors.tuna.tsinghua.edu.cn/homebrew-bottles/api"export HOMEBREW_BOTTLE_DOMAIN="https://mirrors.tuna.tsinghua.edu.cn/homebrew-bottles"export HOMEBREW_BREW_GIT_REMOTE="https://mirrors.tuna.tsinghua.edu.cn/git/homebrew/brew.git"export HOMEBREW_CORE_GIT_REMOTE="htt...

Autogen多智能体交接

Autogen多智能体交接 https://microsoft.github.io/autogen/stable//user-guide/core-user-guide/design-patterns/handoffs.html AutoGen 在多智能体系统里是 如何实现“任务从一个代理(agent)转移/交接(handoff)给另一个代理” 的? 文档中“交接(handoff)”场景的总体结构 一个用户发起对话,会话是由多个 agent + 人类 agent 组成的团队处理。例子里有 “分类代理”(Triage Agent)、“退款代理” / “问题和修复代理”(Issues & Repairs Agent)、“销售代理”、“人类代理”。 起始 agent(classification / triage)负责判断用户意图,然后决定任务应交给哪一个子 agent,比如是销售还是退款问题等。 Agent 可以自己处理任务(调用某些功能/工具)也可以认定自己能力不够,就通过一个“委托工具”(delegate tool)将任务交给另一个 agent。 “交接”的关键机...

GPU资源共享/抢占

GPU共享的整体架构 这个项目是一个Kubernetes GPU共享调度系统,通过两种类型的pod实现GPU资源共享: 1. Shadow Pod(影子Pod) 作用:占用物理GPU资源,作为GPU的实际持有者 特征:运行一个简单的sleep容器,不执行实际计算任务 创建时机:当quota资源不足时自动创建 生命周期:由shadow controller管理,根据使用情况自动创建和删除 2. Share Pod(共享Pod) 作用:实际执行计算任务的pod,通过device plugin共享shadow pod的GPU资源 特征:使用虚拟GPU设备,通过时间片或空间分割方式共享物理GPU 资源请求:请求共享GPU资源(如mizar.share.gpu.2表示2路共享) 核心逻辑链路 1. 配额管理(Quota Controller) 监控quota资源状态,计算shadow resource需求 维护shadow pod与物理GPU的映射关系 处理shadow pod的创建和删除逻辑 2. Shadow Pod管理(Shadow Controller) 创建逻辑:当...

MTU探测

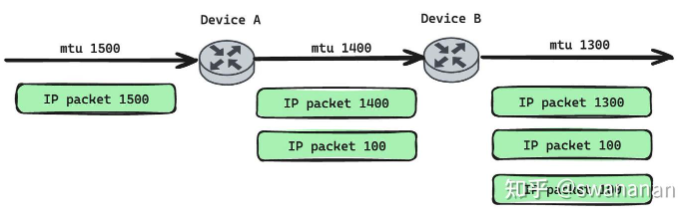

MTU探测 https://zhuanlan.zhihu.com/p/1939977507236450569 PMTUD 是一种用于确定从源主机到目标主机的整个网络路径上 MTU(Maximum Transmission Unit,最大传输单元)大小的机制。它的主要目的是避免 IP 分片,因为分片会消耗额外的计算资源并可能增加丢包的风险。 核心思想: PMTUD 利用 ICMP(Internet Control Message Protocol)的“Fragmentation Needed and DF set”(需要分片但 DF 位已设置)消息来工作。源主机发送一个设置了“Don’t Fragment”(DF)标志位的数据包,如果路径上的某个路由器发现这个数据包太大而无法转发,并且 DF 位被设置,它就不能进行分片,而是丢弃该数据包并向源主机发送一个 ICMP 错误消息,告知源主机路径 MTU 的信息。 详细过程: 初始化: 源主机(Host A)想要向目标主机(Host B)发送一个较大的 IP 数据包。 Host A 会维护一个“路径 MTU 缓存”,记录它所知道的到...

Agent 可观测性+eval

Agent 可观测性+eval AI Agent 应用的在线可观测性(Observability)和评估(Evaluation)系统的设计方案。 它的核心目标是替代现有的、部署和维护成本较高的 Langfuse 平台,构建一个更轻量、易维护、且能满足特定需求(如与现有 Agent 代码集成、进行自动化评估)的内部平台。 具体是做什么? 在线可观测性 (Observability/Trace): 目的: 记录和追踪 Agent 应用的运行过程,特别是它与大型语言模型(LLM)的交互以及内部工具调用(Tool Calling)的详细情况。 内容: 收集 Agent 一次完整交互(称为 Trace)以及其中的各个步骤(称为 Span/Observation)的详细信息,包括: Trace: 整个交互的开始/结束时间、用户输入 (input)、Agent 输出 (output)、使用的模型、Token 消耗量、会话 ID (session.id)、Agent 身份 (resource_attributes.service.name) 等。 Span: Agent 内部的特定操作,...

Vxlan && 四表五链

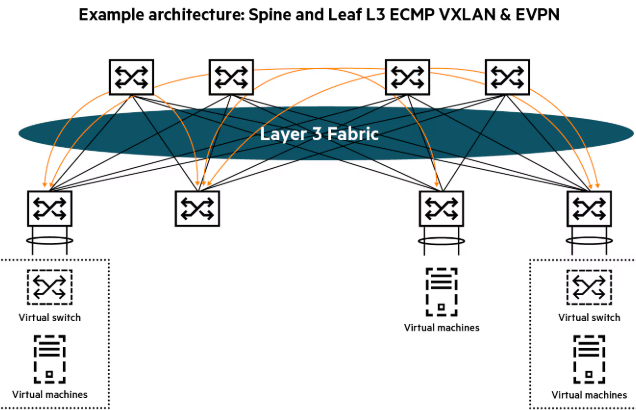

Vxlan && 四表五链 我来为您详细介绍VXLAN和四表五链这两个重要的网络技术概念。 VXLAN (Virtual eXtensible Local Area Network) 基本概念 VXLAN是一种网络虚拟化技术,用于解决传统VLAN的4094个网络标识限制,并实现跨三层网络的二层网络扩展。 核心特点 扩展性强:支持1600万个虚拟网络(24位VNI) 跨三层传输:可以在IP网络上传输二层帧 隧道技术:使用UDP封装实现Overlay网络 报文封装结构 1原始以太网帧 + VXLAN头部 + UDP头部 + IP头部 + 外层以太网帧 主要组件 VTEP (VXLAN Tunnel End Point):隧道端点 VNI (VXLAN Network Identifier):网络标识符 Underlay网络:底层IP网络 Overlay网络:虚拟网络 应用场景 数据中心网络虚拟化 云计算环境租户隔离 跨数据中心的二层网络互联 四表五链 四表 raw表:用于数据包的早期处理,连接跟踪前的处理 mangle表:用于修改数据包的特定部分(TTL...

Volcano调度器

参考:https://zhuanlan.zhihu.com/p/700565336 在 Volcano 系统中,“Job” 和 “Task” 这两个词在 调度器(Scheduler)内部 和 用户/控制器(Controller)层面 代表的是完全不同的东西。 https://volcano.sh/zh/docs/ 丰富的调度策略 Gang Scheduling:确保作业的所有任务同时启动,适用于分布式训练、大数据等场景 Binpack Scheduling:通过任务紧凑分配优化资源利用率 Heterogeneous device scheduling:高效共享GPU异构资源,支持CUDA和MIG两种模式的GPU调度,支持NPU调度 Proportion/Capacity Scheduling:基于队列配额进行资源的共享/抢占/回收 NodeGroup Scheduling:支持节点分组亲和性调度,实现队列与节点组的绑定关系 DRF Scheduling:支持多维度资源的公平调度 SLA Scheduling:基于服务质量的调度保障 Task-topology Schedulin...

NUMA-Aware Scheduling介绍

NUMA-Aware Scheduling https://zhuanlan.zhihu.com/p/713060080 一、 什么是 NUMA? NUMA (Non-Uniform Memory Access,非统一内存访问) 是现代多处理器服务器(尤其是AI服务器)的标准架构。 核心思想:将CPU和内存划分为多个“节点”(Node)。每个节点内的CPU访问本节点的内存速度极快(本地内存访问),而访问其他节点的内存则速度较慢(远程内存访问),存在显著的延迟和带宽差异。 类比:想象一个办公室有多个小组,每个小组有自己的文件柜(本地内存)。找自己组的文件柜拿资料很快,但去别的组借资料就要走过去,花时间。 在一台配备8块GPU和2个CPU插槽的AI服务器上,通常会形成2个或4个NUMA节点。GPU通常通过PCIe总线直连到某个特定的CPU(NUMA节点)上。 二、 为什么需要 NUMA-Aware Scheduling? 在传统的、非NUMA感知的调度下,操作系统或调度器(如K8s原生调度器)可能会做出灾难性的决策: 场景:一个需要大量内存的大模型推理Pod被调度到NUMA ...

io uring学习

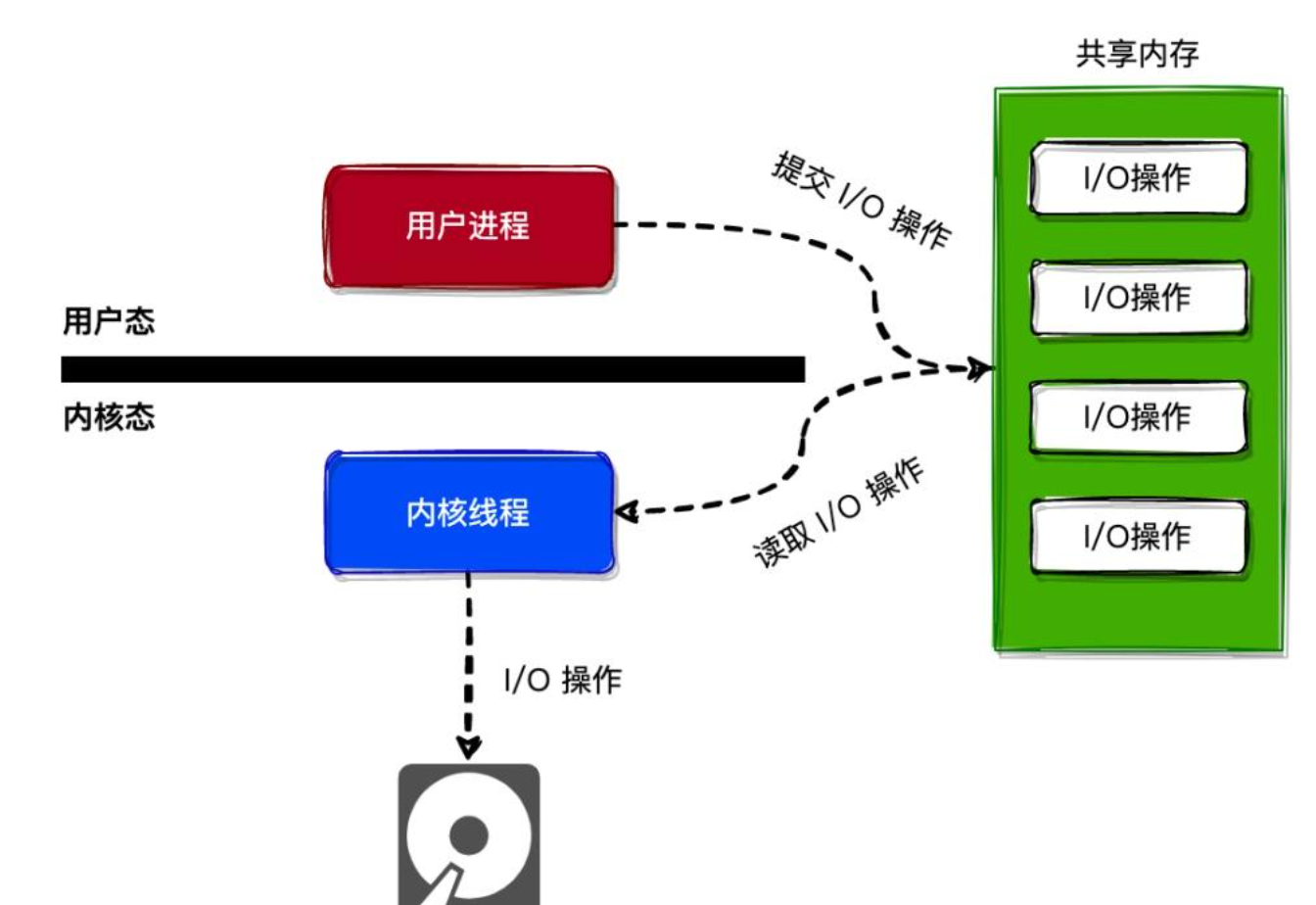

看这个就行 https://arthurchiao.art/blog/intro-to-io-uring-zh/ 阻塞式I/O与非阻塞式I/O 1. 阻塞式 I/O 的问题 在最原始的模型中,应用程序调用 read() 或 write() 时,如果数据没有准备好(例如,网络包未到达,或磁盘数据未从硬盘读入内存),进程就会被挂起(阻塞),直到操作完成。这在高并发场景下是灾难性的,因为一个线程只能处理一个请求。 2. 非阻塞 I/O + I/O 多路复用 (select/poll/epoll) 的“伪异步” 为了解决阻塞问题,引入了非阻塞 I/O 和 I/O 多路复用机制。 工作方式:应用程序将文件描述符(fd)设置为非阻塞模式,然后使用 epoll 等系统调用来“监听”一组 fd。当 epoll_wait() 返回时,它会告诉你哪些 fd 已经“就绪”(ready),即可以进行无阻塞的读写操作。 优点:一个线程可以同时管理成千上万个网络连接,极大地提升了并发能力。这也是 Node.js、Nginx、Redis 等高性能服务的基石。 3. 致命缺点:仅限于“就绪通知”,且不支持 ...

K8s drain和cordon的区别

K8s drain和cordon的区别 Kubernetes中Drain和Cordon的区别 Cordon(封锁节点) 作用 标记节点为不可调度 新的Pod不会被调度到该节点 现有Pod不受影响,继续正常运行 使用场景 12345# 封锁节点kubectl cordon node-name# 解除封锁kubectl uncordon node-name 实际效果 1234节点状态变化:- 调度状态:可调度 → 不可调度- 现有Pod:继续运行- 新Pod:不会调度到此节点 Drain(排空节点) 作用 首先执行Cordon操作(封锁节点) 优雅地驱逐节点上的所有Pod 等待Pod在其他节点上重新启动 节点变为空节点 使用场景 1234567891011# 排空节点(默认行为)kubectl drain node-name# 排空节点并忽略DaemonSetkubectl drain node-name --ignore-daemonsets# 强制删除(不等待优雅终止)kubectl drain node-name --force# 设置优雅终止时间kubectl dri...