Pytorch框架学习

Pytorch框架学习 [conda常用命令汇总_conda info-CSDN博客](https://blog.csdn.net/raelum/article/details/125109819?ops_request_misc={"request_id"%3A"FDEA5F49-A7E0-4BF5-99F9-B75BE8373F14"%2C"scm"%3A"20140713.130102334.."}&request_id=FDEA5F49-A7E0-4BF5-99F9-B75BE8373F14&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~all~top_click~default-2-125109819-null-null.142^v100^pc_search_result_base8&utm_term=conda 命令&spm=1018.2226.3001.4187) ...

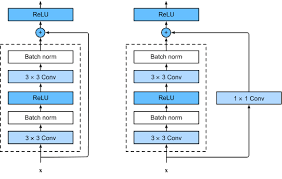

ResNet

ResNet 视频:ResNet论文逐段精读【论文精读】_哔哩哔哩_bilibili 【深度学习】ResNet网络讲解-CSDN博客 深度学习基础学习-残差-CSDN博客 为什么要使用3×3卷积?& 11卷积的作用是什么?& 对ResNet结构的一些理解_33卷积-CSDN博客 残差、方差、偏差、MSE均方误差、Bagging、Boosting、过拟合欠拟合和交叉验证-CSDN博客 深度学习——残差网络(ResNet)原理讲解+代码(pytroch)_残差神经网络-CSDN博客 :star: 快速理解卷积神经网络的输入输出尺寸问题_卷积神经网络输入和输出-CSDN博客 CNN基础知识——卷积(Convolution)、填充(Padding)、步长(Stride) - 知乎 (zhihu.com) 正态及标准正态分布-CSDN博客 [ 图像分类 ] 经典网络模型4——ResNet 详解与复现-CSDN博客 现象:更深的网络结构反而训练误差和测试误差都提升了!(梯度消失/梯度爆炸) 这里和overfiiting的区别是:过拟合是训练集上表现好,但测试集表现差,这里的...

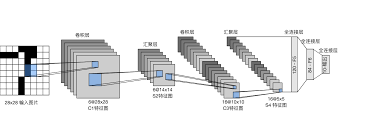

CNN笔记

CNN笔记 CNN笔记:通俗理解卷积神经网络_cnn卷积神经网络-CSDN博客 Zero Padding(零填充)——在卷积神经网络中的作用?-CSDN博客 一句话CNN:如何理解padding的作用和算法 - 知乎 (zhihu.com) 为什么需要随机裁剪:随机裁剪相当于建立每个因子特征与相应类别的权重关系,减弱背景(或噪音)因子的权重,且使模型面对缺失值不敏感,也就可以产生更好的学习效果,增加模型稳定性。

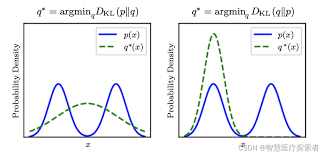

KL散度详解

KL散度 进阶详解KL散度 - 知乎 (zhihu.com)

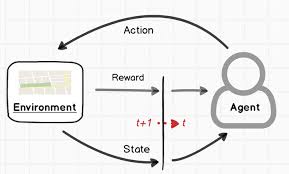

RLHF

RLHF 从零实现ChatGPT——RLHF技术笔记 - 知乎 (zhihu.com) 一文读懂「RLHF」基于人类反馈的进行强化学习-CSDN博客 大模型 | 通俗理解RLHF基础知识以及完整流程-CSDN博客

Lora大模型微调

Lora大模型微调 LoRA微调方法详解-CSDN博客 理解Lora微调只需一个公式-CSDN博客 【LLM】金融场景的大模型Lora微调实战_金融微调数据集-CSDN博客 LoRA原理很简单, 代码实现也不复杂。 简单地说,在模型实现上, 要在特定的模块上加一个旁路, 这个旁路就是两个矩阵相乘的形式。这些特定的模块理论上可以是任何模块, 目前作者实现的是在Linear, Embeding, Conv, Attention(只改其中的q和v)这些模块上加。 关键代码: 12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758596061626364656667686970717273747576777879808182838485class LoRALayer(): def __init__( self, r: int, lora_alpha: int, l...

Seq2Seq

Seq2Seq和Word2Vec Seq2Seq Seq2Seq模型介绍 - 知乎 (zhihu.com) Word2Vec 深入浅出Word2Vec原理解析 - 知乎 (zhihu.com) 一文搞懂One-Hot编码与词嵌入(Embedding)-百度开发者中心 (baidu.com) 如何通俗理解Word2Vec (23年修订版)-CSDN博客 :star: 传统的one-hot 编码仅仅只是将词符号化,不包含任何语义信息。而且词的独热表示(one-hot representation)是高维的,且在高维向量中只有一个维度描述了词的语义 (高到什么程度呢?词典有多大就有多少维,一般至少上万的维度)。所以我们需要解决两个问题: 需要赋予词语义信息 降低维度 Word2Vec:最终词向量的维度(与隐含层结点数一致)一般情况下要远远小于词语总数 的大小,所以 Word2vec 最有价值的是 让不带语义信息的词带上了语义信息 其次把词语从 one-hot encoder 形式的表示降维到 Word2vec 形式的表示 CBOW(通过上下文推断某个词) 将上下文词进行 ...

强化学习笔记

强化学习笔记 强化学习极简入门:通俗理解MDP、DP MC TC和Q学习、策略梯度、PPO-CSDN博客

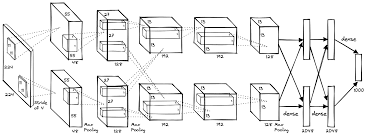

AlexNet解析

AlexNet解析 卷积神经网络经典回顾之AlexNet - 知乎 (zhihu.com) AlexNet论文逐段精读【论文精读】_哔哩哔哩_bilibili 饱和:saturating 非饱和:non-saturating

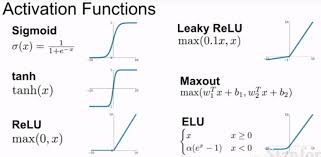

饱和(saturating)和非饱和(non-saturating)的激活函数

饱和(saturating)和非饱和(non-saturating)的激活函数 在神经网络中,激活函数是决定网络能否学习复杂模式的关键因素之一。激活函数的选择会影响网络的收敛速度、性能以及最终的泛化能力。激活函数可以根据其输出特性被分为“饱和”(saturating)和“非饱和”(non-saturating)两大类: 饱和激活函数(Saturating Activation Functions) 定义: 饱和激活函数是指当输入值增大或减小时,函数的输出值会达到一个上限或下限,并在该范围内趋于稳定,不再随输入的增加而显著变化。 特点: 输出值存在一个明显的上限和下限。 当输入值增大到一定程度后,输出值不再显著增加(或减少)。 例子: Sigmoid 函数:[ \sigma(x) = \frac{1}{1 + e^{-x}} ] Tanh 函数(双曲正切函数):[ \tanh(x) = \frac{2}{1 + e^{-2x}} - 1 ] ReLU 函数(Rectified Linear Unit)在正区间内是非饱和的,但在负区间内是饱和的。 影响: ...