LLM强化学习算法演进之路:MC->TD->Q-Learning->DQN->PG->AC->TRPO->PPO->DPO->GRPO

发表于|更新于|llm

|浏览量:

LLM强化学习算法演进之路:MC->TD->Q-Learning->DQN->PG->AC->TRPO->PPO->DPO->GRPO

文章作者: Roger-Lv

版权声明: 本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Roger-Lv's space!

相关推荐

2025-08-21

一行代码,解锁SFT泛化能力:深度解读DFT如何完胜传统微调

一行代码,解锁SFT泛化能力:深度解读DFT如何完胜传统微调 转自:https://mp.weixin.qq.com/s/XXGxRk-p5LahtqdYNnbKaA 在大型语言模型 (LLM) 的世界里,如何让模型更好地理解并遵循人类的指令,即所谓的“对齐”,始终是核心议题。目前,主流的技术路线分为两条:监督微调(Supervised Fine-Tuning, SFT)和基于人类反馈的强化学习 (Reinforcement Learning from Human Feedback, RLHF)。 SFT 简单直接,就像教一个学生做题,直接给他看大量的“问题-标准答案”对,让他去模仿。 这种方法易于实现,能让模型快速学会特定任务的“套路”。然而,它的弊病也十分明显——模型容易“死记硬背”,学到的知识很“脆”,泛化能力差,遇到没见过的题型就可能“翻车”。 相比之下,RLHF 更像是请一位教练来指导学生。它不直接给出答案,而是对模型的不同回答给出评分(奖励),让模型在不断的尝试和反馈中,自己探索出更好的策略。但它的问题在于,训练过程极其复杂,需要耗费大量的计算资源,对超参数敏感,且依...

2025-08-21

SFT专攻Pass@k,RL强化Pass@1?

深挖RLVR探索机制:SFT专攻Pass@k,RL强化Pass@1 转自:https://mp.weixin.qq.com/s/QSi580SJ2RFewyFirAe65A 先前的工作已经证明了 RLVR 在实践中的成功,但其背后的根本机制,特别是模型在训练过程中的探索行为,仍有待深入研究。来自中国人民大学高瓴人工智能学院的研究者们发表了一篇题为《From Trial-and-Error to Improvement: A Systematic Analysis of LLM Exploration Mechanisms in RLVR》的技术报告,系统性地研究了RLVR 中的探索机制。 论文题目:From Trial-and-Error to Improvement: A Systematic Analysis of LLM Exploration Mechanisms in RLVR 论文链接:https://arxiv.org/pdf/2508.07534 这篇报告结合了详尽的文献回顾和创新的实证分析,围绕探索空间塑造、熵与性能的相互作用以及强化学习性能优化这三个维度...

2025-08-21

Agentic RL

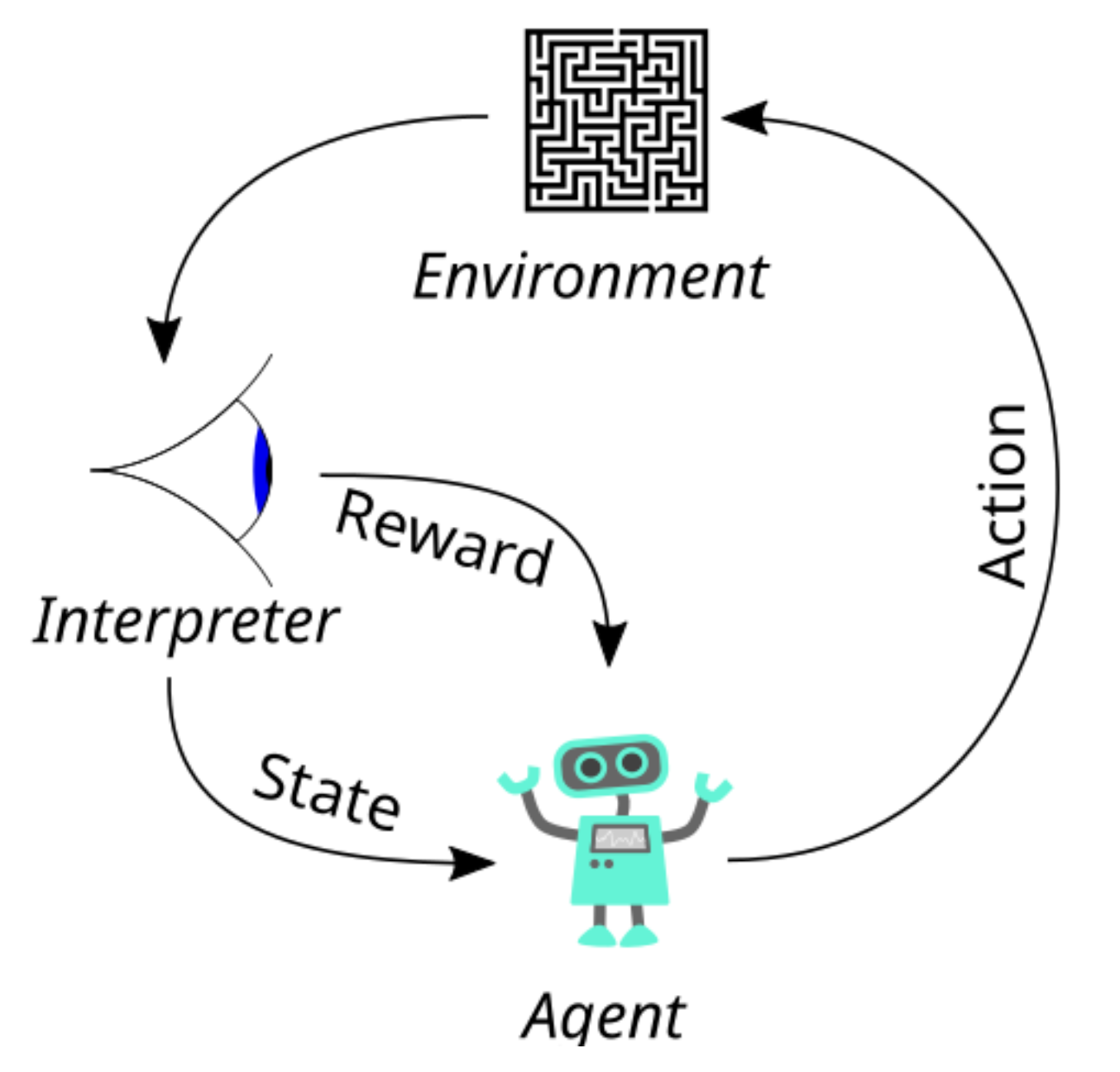

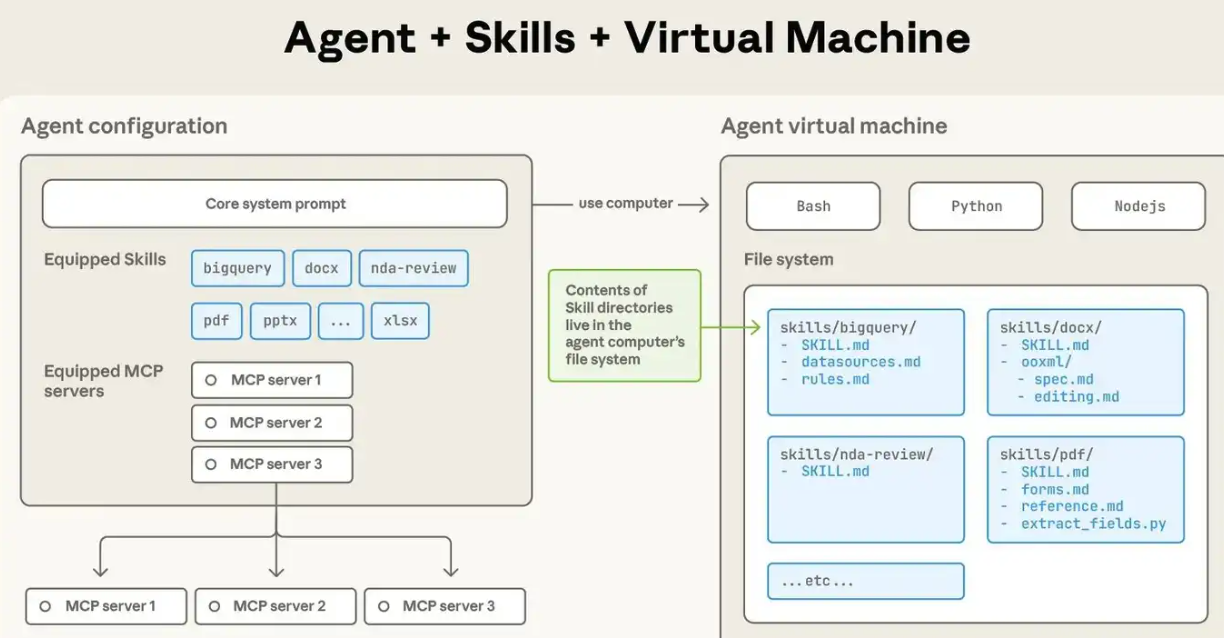

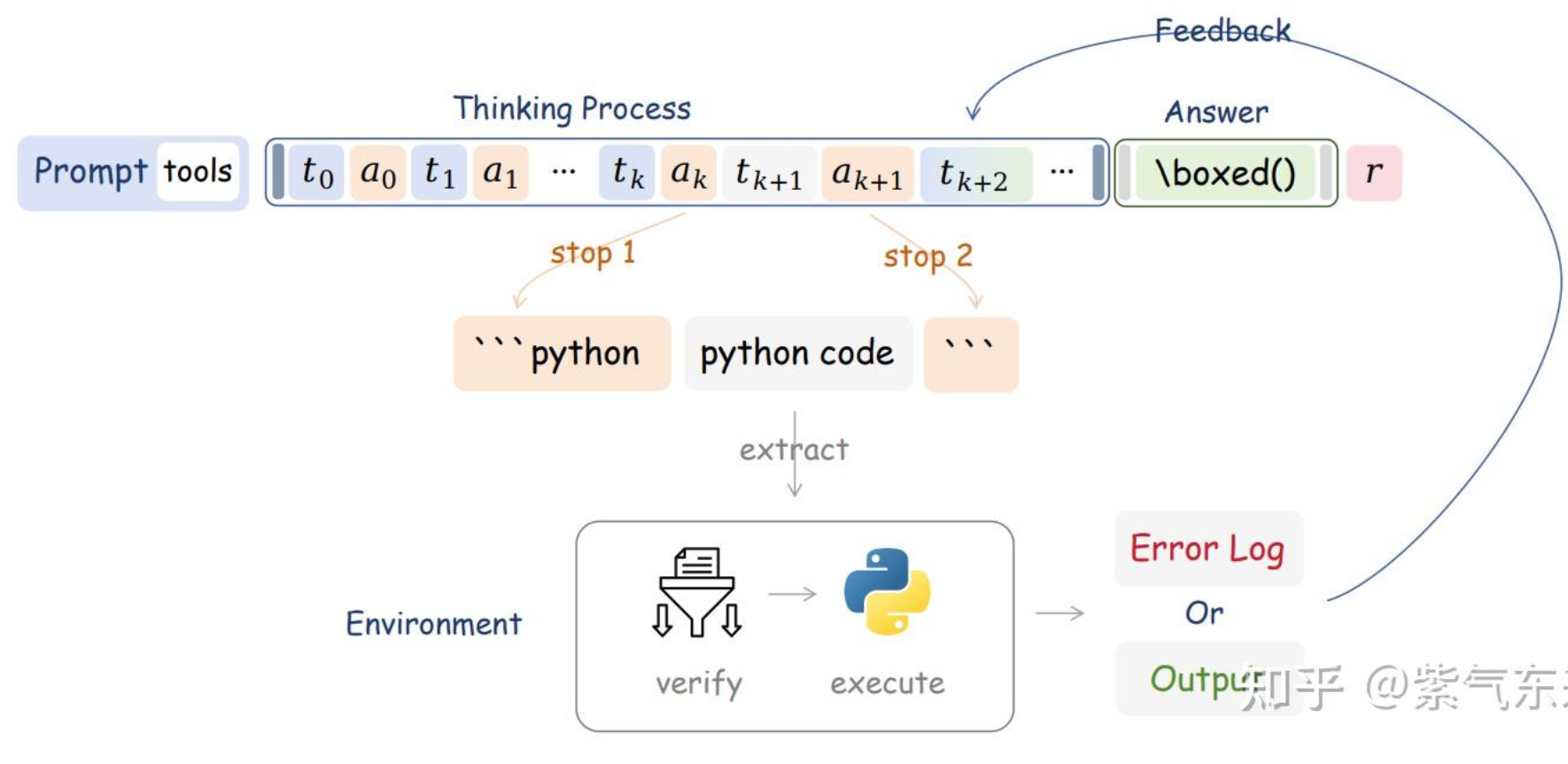

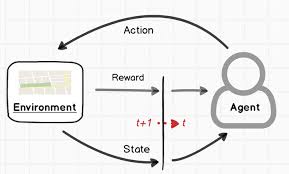

转自:https://zhuanlan.zhihu.com/p/1913905349284591240 通过蒙特卡洛树搜索、过程监督与结果监督、强化学习来提高 LLM 的推理能力,从本质上来说,都是尽可能榨取 LLM 本身的能力,区别可能在于多次尝试、反馈信号、训练方法而已,这类方法可称之为“求诸内”。而由 scaling law 可知,模型的能力是有限的,那么该如何进一步提高LLM在具体问题上的表现呢?近期的答案是,类似 RAG,Multi-Agent 系统,让 LLM 学会使用工具,毕竟人与动物的关键区别也只是“能制造并使用工具”,这种方式则是“求诸外”。那么本篇就以此为中心,重点讨论以下问题: Agentic LLM 的算法逻辑、具体方法与实际表现? RL 如何训练 Agentic LLM,其与 tool using 的 SFT 的差异在哪? Agentic RL 的工程化问题 一、Agentic RL 的算法设计 Agent 和 RL 都并非新鲜事物,而使用 RL 训练基于 LLM 的 agent 则是近期的研究的热点,那么,从算法角度来说,如何理解二者结合的动机、场...

2025-08-21

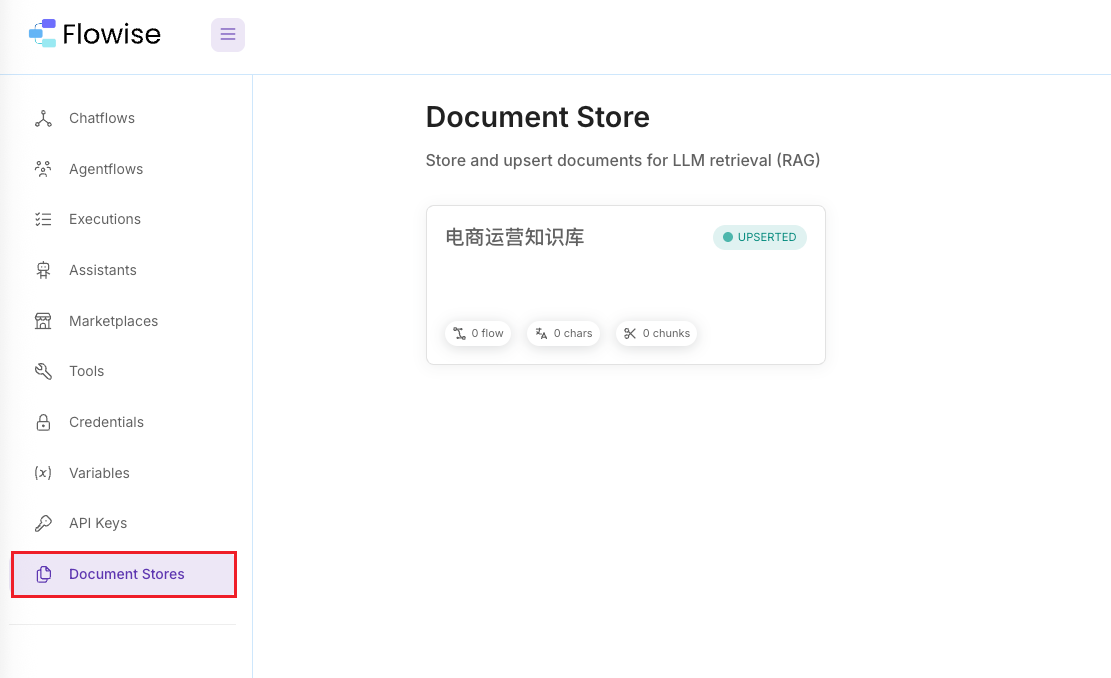

使用 Flowise 构建基于私有知识库的智能客服 Agent(图文教程)

使用 Flowise 构建基于私有知识库的智能客服 Agent(图文教程) https://blog.csdn.net/hejiahao_/article/details/147902607?fromshare=blogdetail&sharetype=blogdetail&sharerId=147902607&sharerefer=PC&sharesource=a1150568956&sharefrom=from_link

2025-09-01

UI-R1:通过强化学习增强GUI代理的动作预测能力

UI-R1:通过强化学习增强GUI代理的动作预测能力 最近的DeepSeek-R1展示了通过基于规则的强化学习(RL)在大型语言模型(LLMs)中涌现出的推理能力。基于这一理念,我们首次探索了如何利用基于规则的RL来增强多模态大语言模型(MLLMs)在图形用户界面(GUI)动作预测任务中的推理能力。 为此 我们精心整理了一个包含136个具有挑战性任务的小而高质量的数据集,涵盖了移动设备上的五种常见动作类型。 我们还引入了一种统一的基于规则的动作奖励机制,使模型可以通过基于策略的算法(如组相对策略优化(GRPO))进行优化。 实验结果表明,我们提出的数据高效模型 UI-R1-3B 在领域内(ID)和领域外(OOD)任务上都取得了显著改进。具体来说,在ID基准测试 AndroidControl 上,动作类型准确率提高了 15% ,而定位准确率提高了 10.3% ,相较于基础模型(即Qwen2.5-VL-3B)。在OOD GUI定位基准ScreenSpot-Pro上,我们的模型超越了基础模型,提高了 6.0% ,并实现了与更大模型(例如OS-Atlas-7B)相当的性能,这些模型是...

2025-09-01

Web Agent综述

WebAgents综述:大模型赋能AI Agent,实现下一代Web自动化 https://finance.sina.cn/tech/csj/2025-08-08/detail-infkhmtz1833863.d.html?vt=4&cid=206650&node_id=206650 这篇文章是香港理工大学研究人员发表的首篇关于WebAgents的系统性综述,全面梳理了基于大模型的Web自动化智能体研究进展。 核心内容 背景与意义 互联网已深度重塑生活,但网络活动存在大量重复低效的"数字苦力"(如反复填写个人信息、手动比对商品参数) WebAgents能够根据用户自然语言指令自动完成复杂Web任务,实现网络活动的自动化与智能化 例如ChatGPT Agent能独立规划执行任务,无需用户持续监督 WebAgents架构 文章将WebAgents工作流程分为三个关键环节: 感知:观察环境 基于文本(利用HTML等) 基于视觉(利用截图) 多模态(结合文本与视觉信息) 规划与推理:分析环境并决策 任务规划(显式/隐式分解任务) 动作...

评论

公告

Welcome!