RL for LLM 高质量文章汇总

RL for LLM 高质量文章汇总 算法 PPO Proximal Policy Optimization Algorithms 日期:2017.08.28 从头理解PPO(Proximal Policy Optimization):从公式到代码 图解大模型RLHF系列之:人人都能看懂的PPO原理与源码解读 人人都能看懂的RL-PPO理论知识 RLOO Back to Basics: Revisiting REINFORCE Style Optimization for Learning from Human Feedback in LLMs 日期:2024.02.22 大模型 | PPO 和 DPO 都不是 RLHF 的理想形式 一文对比4种 RLHF 算法:PPO, GRPO, RLOO, REINFORCE++ GRPO DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models 日期:2024.04.27 DeepSeek的GRPO算法是什么? 强化学习...

DeepAgents:基于LangChain的下一代智能代理框架

DeepAgents:基于LangChain的下一代智能代理框架 https://docs.langchain.com/oss/python/deepagents/overview 概述 DeepAgents是一个构建在LangChain之上的高级智能代理框架,旨在提供更强大、更灵活的代理构建能力。该框架通过模块化设计,为开发者提供了文件系统操作、子代理管理、可插拔后端存储等核心功能,使得构建复杂的多步骤AI代理变得更加简单和高效。 DeepAgents构建在以下基础之上: LangGraph - 提供底层图执行和状态管理 LangChain——工具和模型集成与深度代理无缝协作 LangSmith - 可观测性、评估和部署 例子:https://zhuanlan.zhihu.com/p/1979938537802597911 核心架构 DeepAgents采用分层架构设计,主要包含以下核心模块: 1. 核心入口模块(graph.py) create_deep_agent():框架的主要入口函数,用于创建深度代理 默认使用Claude Sonnet 4作为模型 内置多种中间件...

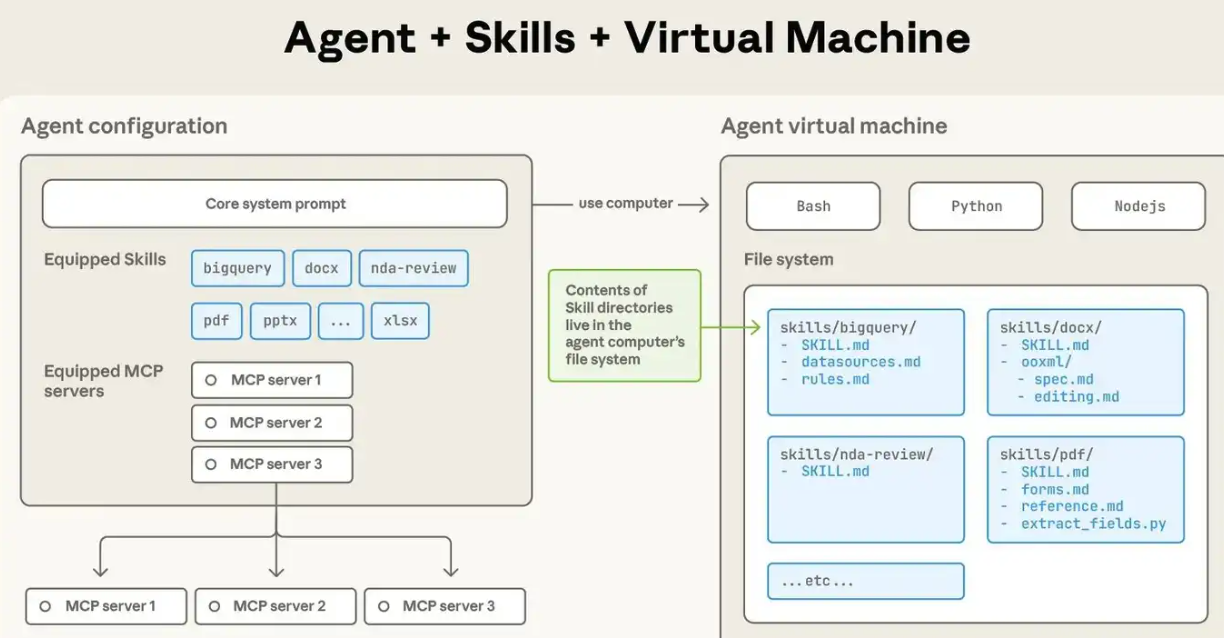

Anthropic skils解读与实践

Anthropic skils解读与实践 https://github.com/anthropics/skills 全流程周期:https://zhuanlan.zhihu.com/p/1984015383276041355 介绍 二者都是扩展LLM能力的一种手段。 Agent Skills 是一种标准化的程序性知识封装格式。如果说 MCP 为智能体提供了"手"来操作工具,那么 Skills 就提供了"操作手册"或"SOP(标准作业程序)",教导智能体如何正确使用这些工具。 这种设计理念源于一个简单但深刻的洞察:连接性(Connectivity)与能力(Capability)应该分离。MCP 专注于前者,Skills 专注于后者。这种职责分离带来了清晰的架构优势: MCP 的职责:提供标准化的访问接口,让智能体能够"够得着"外部世界的数据和工具 Skills 的职责:提供领域专业知识,告诉智能体在特定场景下"如何组合使用这些工具" MCP 在使用上的不同之处在于,MCP的流程是...

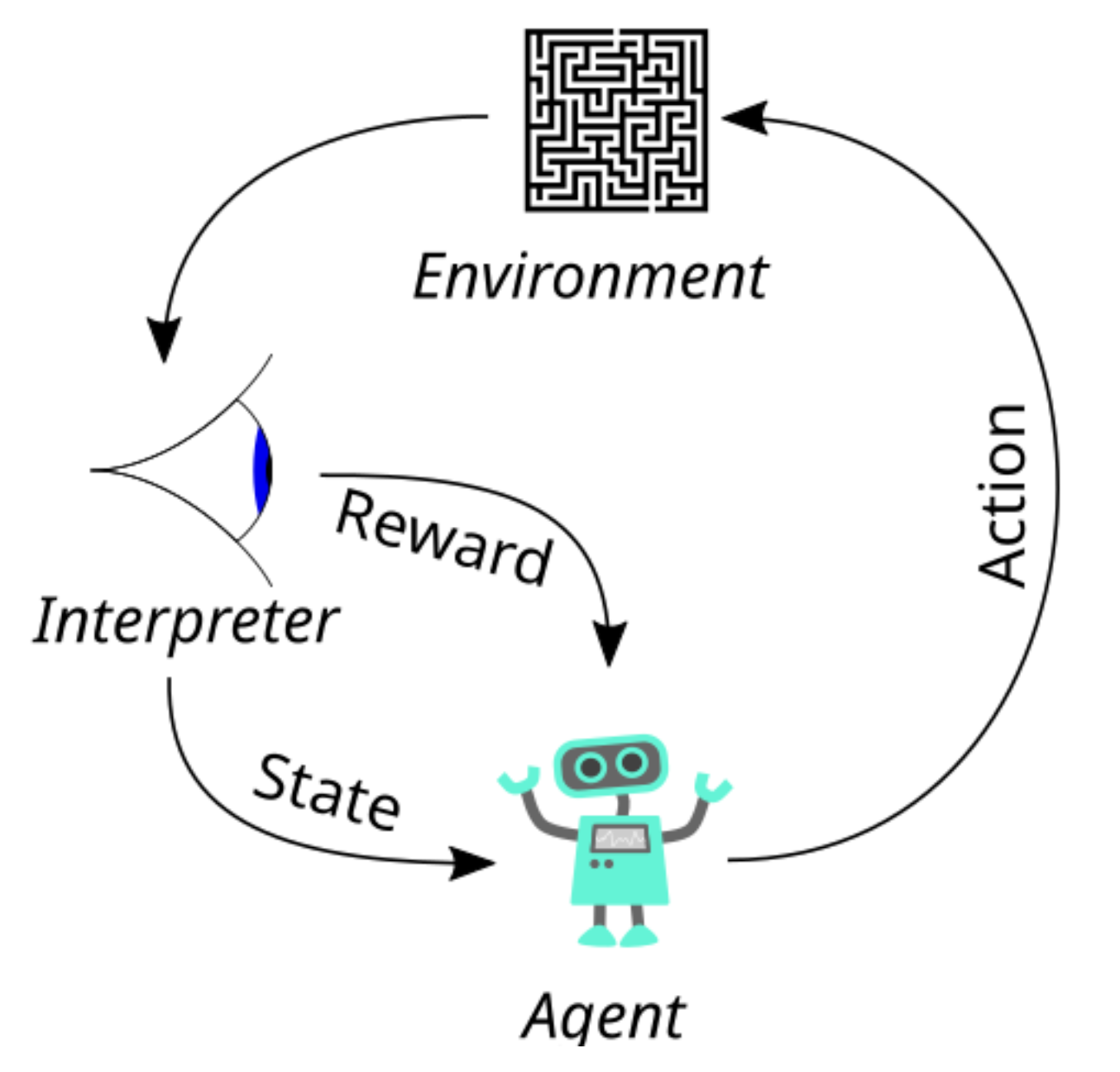

LLM强化学习算法演进之路:MC->TD->Q-Learning->DQN->PG->AC->TRPO->PPO->DPO->GRPO

LLM强化学习算法演进之路:MC->TD->Q-Learning->DQN->PG->AC->TRPO->PPO->DPO->GRPO https://zhuanlan.zhihu.com/p/20949520788: 这文章很详细

pytorch学习

pytorch学习 简单例子(包含数据集加载、训练、模型保存和测试) 一个基本的例子:https://zhuanlan.zhihu.com/p/508721527 加载数据 12torchvision.datasets.CIFAR10torch.utils.data.DataLoader() 训练网络 12345678910111213141516171819202122232425262728293031import torch.nn as nnimport torch.nn.functional as Fclass Net(nn.Module): def __init__(self): super(Net, self).__init__() # 第一层卷积:输入通道3(RGB图像),输出通道6,卷积核大小5×5 self.conv1 = nn.Conv2d(3, 6, 5) # 池化层:2×2最大池化,步长为2 self.pool = nn.MaxPool2d(2, 2) # 第二层卷积...

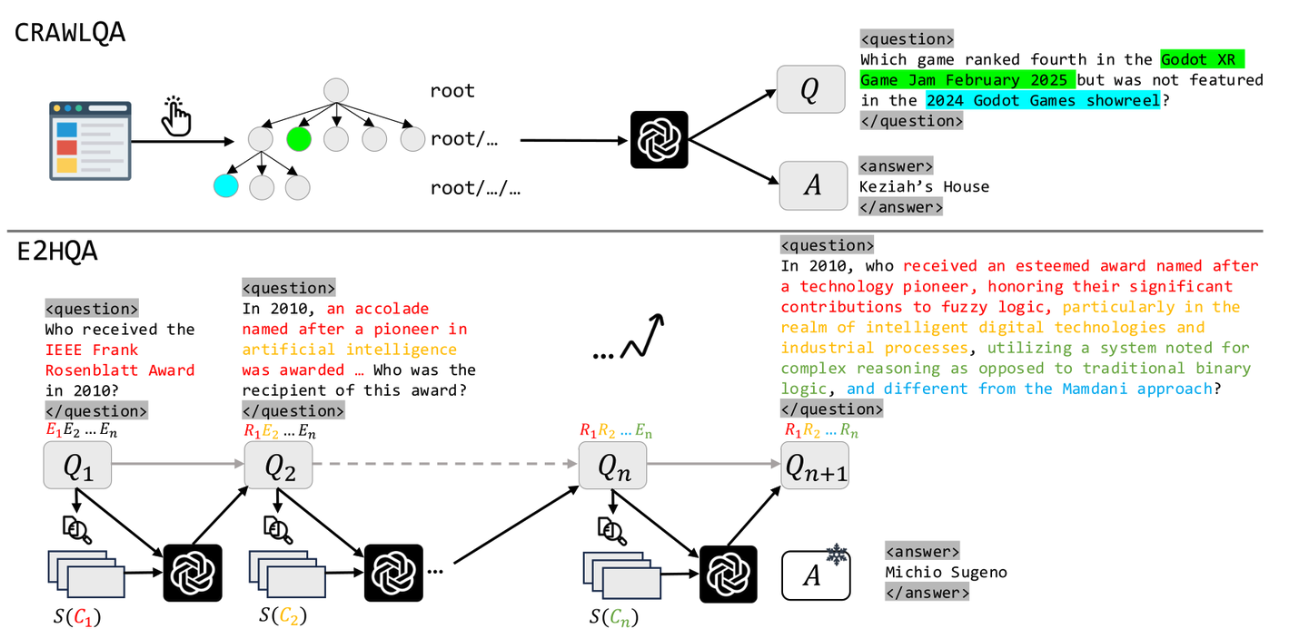

WebDancer:Towards Autonomous Information Seeking Agency

WebDancer: Towards Autonomous Information Seeking Agency 论文标题:WebDancer: Towards Autonomous Information Seeking Agency 论文链接:https://arxiv.org/pdf/2505.22648 论文代码:https://github.com/Alibaba-NLP/DeepResearch 这篇论文介绍了一个基于ReAct范式的网络智能体——WebDancer,通义团队透过训练赋予其自主寻求信息的能力。通义团队的训练流程主要有四个步骤,构造问答对、获得高质量轨迹、监督微调和强化学习。 问答对构造 不同于之前的简单的2到3步就能解决的问答问题,通义团队这里主要想构造的是那些可以激发模型多步推理、目标分解、交互等能力的问答对数据,因此希望对多跳推理的广度和深度都进行扩展。为此,他们提出了两个问答对数据集——CRAWLQA和E2HQA。 CRAWLQA问答对的获取跟之前WebWalkerQA数据集的构造很类似,都是从一个根网页出发递归浏览其中链接指向的网页,基于收集的...

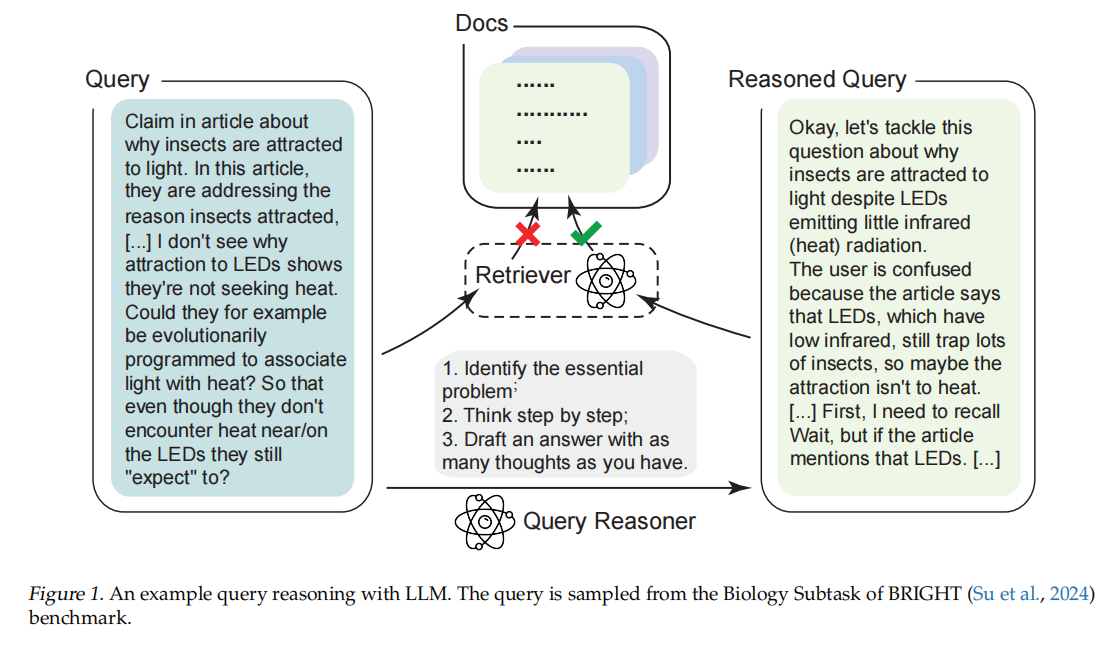

TongSearch-QR:Reinforced Query Reasoning for Retrieval

TongSearch-QR: Reinforced Query Reasoning for Retrieval 这篇论文《TongSearch-QR: Reinforced Query Reasoning for Retrieval》提出了一种面向推理密集型检索(reasoning-intensive retrieval)任务的新型查询推理与重写模型家族,旨在解决传统信息检索方法在处理复杂、需要多跳推理的查询时性能不足的问题。 一、问题背景 传统信息检索(IR)方法(如 BM25、稠密向量检索)依赖词法匹配或语义相似度,在一般检索任务上表现良好。但在以下场景中表现不佳: 用户问题隐含深层意图(如“找一个可替代函数 Funca 的函数 Funcb”); 相关文档未显式提及原问题中的关键词; 需要推理链(reasoning chain)才能连接查询与文档。 这类任务被称作 推理密集型检索(reasoning-intensive retrieval),如 BRIGHT 基准测试所定义。 二、现有方法及其局限 1. 大语言模型(LLM)提示工程 使用 GPT-4、LLaMA3-...

Agent八股

Agent八股 模板1 八股:Encoder与decoder的中Attention区别? 答案:https://zhuanlan.zhihu.com/p/26252050300 https://www.zhihu.com/question/588325646/answer/1981416261771604279 八股:Attention如何计算?为什么除以根号下Dk?mask attention是如何实现的? 你的问题涉及 Transformer 模型中 Attention 机制的三个关键点: Attention 的计算方式 为什么除以 (\sqrt{d_k}) Masked Attention 的实现方式 下面逐一解释: Attention 如何计算?(以 Scaled Dot-Product Attention 为例) 标准的 Scaled Dot-Product Attention 公式如下: \[ \text{Attention}(Q, K, V) = \text{softmax}\left( \frac{QK^T}{\sqrt{d_k}} \right) V ...

DeepResearch智能体方案

DeepResearch智能体方案 通义dr的解读: https://zhuanlan.zhihu.com/p/1953262318352863784 关键在于训练一个专门的模型,为DR而生。 为什么通义DeepResearch不需要 chunk?RAG正在被Agent改写 https://zhuanlan.zhihu.com/p/1968442243783294997 CPT->SFT->RL DeepResearch 之所以不需要传统 RAG 的Chunking,是因为它从根本上改变了范式。 传统 RAG 是一个静态系统,模型是被动缝合你喂给它的碎纸片 (Chunks)。 DeepResearch 是一个动态系统。模型是研究员,它主动去获取完整的信息(网页/文档),然后利用IterResearch范式(压缩笔记)来管理自己的认知焦点,再利用RL来优化自己的研究策略。 所以,RAG 不会被取代,而是正在被 DeepResearch 这样的 Agent 框架吸收和升维——检索不再是一个外部模块,而是 Agent 工具箱里一个最基础的动作而已。 JINA 看jina...

LangGraph 八股

LangGraph 八股 官方文档:https://docs.langchain.com/oss/python/releases/langchain-v1 https://zhuanlan.zhihu.com/p/1914230995034564014 langchain&laanggraph 1.0: https://zhuanlan.zhihu.com/p/1966891862062265076 https://zhuanlan.zhihu.com/p/1968427472388335014 langchain新特性: 全新create_agent接口:默认运行在 LangGraph 引擎之上。 中间件定义了一组钩子,允许您自定义代理循环中的行为,从而实现代理采取的每个步骤的细粒度控制;支持自定义中间件 ,这些中间件可以连接到代理循环中的多个点。 钩子函数 触发时机 应用场景 before_agent 在调用代理之前 加载记忆数据、验证输入 before_model 在每次大模型调用之前 更新提示词、精简消息历史 wrap_mod...