TongSearch-QR:Reinforced Query Reasoning for Retrieval

TongSearch-QR: Reinforced Query Reasoning for Retrieval

这篇论文《TongSearch-QR: Reinforced Query Reasoning for Retrieval》提出了一种面向推理密集型检索(reasoning-intensive retrieval)任务的新型查询推理与重写模型家族,旨在解决传统信息检索方法在处理复杂、需要多跳推理的查询时性能不足的问题。

一、问题背景

传统信息检索(IR)方法(如 BM25、稠密向量检索)依赖词法匹配或语义相似度,在一般检索任务上表现良好。但在以下场景中表现不佳:

- 用户问题隐含深层意图(如“找一个可替代函数 Funca 的函数 Funcb”);

- 相关文档未显式提及原问题中的关键词;

- 需要推理链(reasoning chain)才能连接查询与文档。

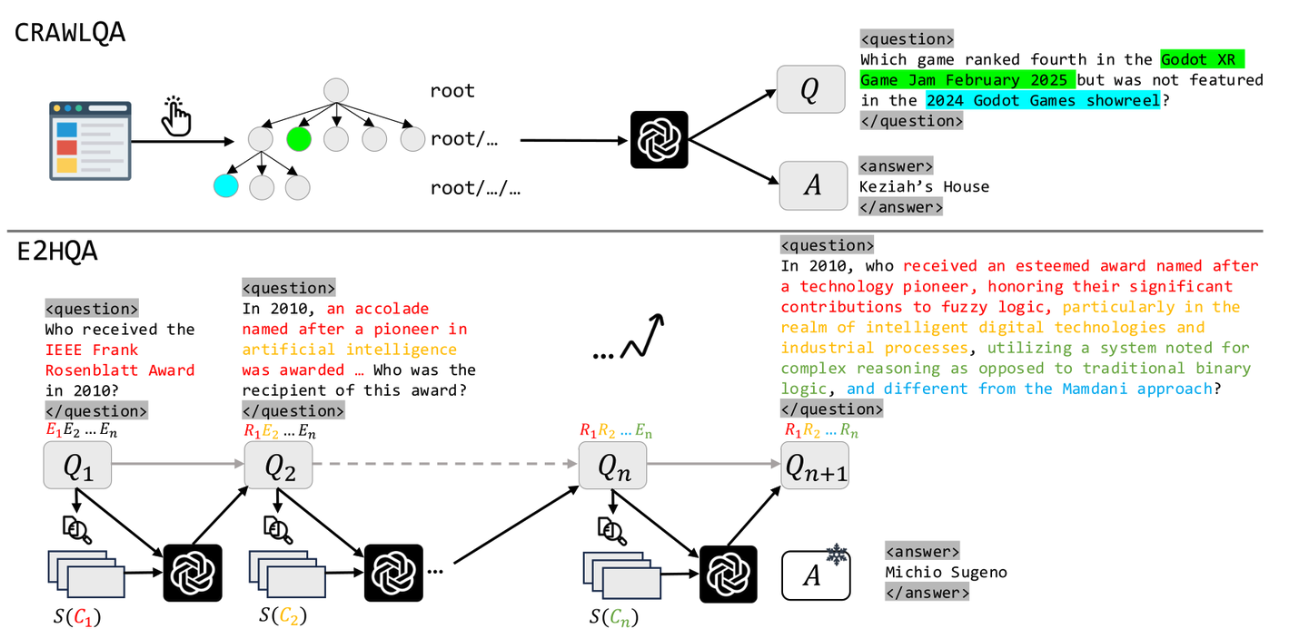

这类任务被称作 推理密集型检索(reasoning-intensive retrieval),如 BRIGHT 基准测试所定义。

二、现有方法及其局限

1. 大语言模型(LLM)提示工程

- 使用 GPT-4、LLaMA3-70B 等大模型进行 Chain-of-Thought 查询重写(query reasoning/rewriting);

- 生成包含推理过程的“伪查询”(reasoned query)用于检索。

缺点:

- 推理成本高;

- 商业模型不可部署(安全/成本/延迟);

- 在 RAG 系统中,查询重写模块通常不应比主模型更大。

2. 专用推理检索器

- 如 ReasonIR:直接训练可推理的检索器。

缺点:

- 需大量标注数据;

- 难以泛化;

- 预编码文档成本高。

三、本文解决方案:TongSearch-QR

核心思想

用小规模语言模型(1.5B/7B)替代大模型,实现高效、低成本、高效果的查询推理与重写。

三大关键技术贡献:

1. TongSearch-QR 模型家族

- 基于 Qwen2.5-1.5B/7B-Instruct 微调;

- 专为推理密集型检索任务设计;

- 支持与任何检索器(BM25、ReasonIR 等)配合使用。

2. 半规则奖励函数(Semi-Rule-Based Reward)

这里用的grpo: https://www.zhihu.com/question/10766825126/answer/88583863333

- 奖励 = 重写查询 vs 原始查询 在正例文档上的平均相关性提升;

- 使用预训练嵌入模型(如 bge-base-en)计算相关性(余弦相似度);

- 优点:

- 无需人工标注推理路径;

- 不依赖过程奖励模型(PRM);

- 抗“奖励黑客”(reward hacking);

- 计算高效、鲁棒。

3. 自动训练数据构建流程

- 利用公开数据集 Stack Exchange Preferences(H4);

- 两种数据构建方式:

- V1:用 QwQ-32B / DeepSeek-R1 生成 CoT 重写(监督信号);

- V2:直接使用用户“选中”的答案作为重写(更真实、更便宜、规模更大)。

- 实验表明 V2 + 强化学习 效果最好。

四、实验结果(BRIGHT 基准)

| 模型 | nDCG@10(BM25) | 成本(USD/1M tokens) | 性价比(性能/成本) |

|---|---|---|---|

| GPT-4o | 26.5 | 10.0 | 2.7 |

| o1-preview | 30.2 | 60.0 | 0.5 |

| DeepSeek-R1 | 29.6 | 2.2 | 13.6 |

| TongSearch-QR-7B | 27.9 | 0.1 | 279.0 |

| TongSearch-QR-1.5B | 24.6 | 0.01 | 2460.0 |

✅ 关键结论:

- TongSearch-QR-7B 超越 GPT-4o,接近 o1-preview;

- 成本仅为大模型的 1/100 ~ 1/1000;

- 与 ReasonIR 检索器配合时,性能进一步提升至 31.9 nDCG@10,创 SOTA。

五、消融实验亮点

-

强化学习 vs 监督微调(SFT):

- SFT 在含噪声的 V2 数据上性能暴跌(12.8 → 24.6);

- RL 因不强制逐 token 拟合,对噪声鲁棒性强。

-

是否需要显式推理(

… ?) - 在查询重写任务中,显式推理无收益;

- 因为“重写查询本身已隐含推理”,无需额外格式。

-

奖励函数中的相关性模型选择:

- 稠密模型(bge-base-en)比稀疏模型(bge-m3)效果更好;

- 更长输出(1000 tokens)反而稀释信号,500 tokens 最佳。

六、总结与意义

- 首次提出专为查询推理训练的小模型家族;

- 通过强化学习 + 半规则奖励,在无标注推理路径条件下实现高性能;

- 极大降低推理密集型检索的部署门槛,适用于真实 RAG 系统;

- 开源:https://github.com/bigai-nlco/TongSearch-QR

🎯 一句话概括:

用 1.5B/7B 小模型,干翻 GPT-4o,成本还不到 1% —— 为推理密集型检索提供高性价比解决方案。

如果你需要对某一部分(如奖励函数设计、数据构建、与 RAG 集成等)做更深入解读,也可以告诉我。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Roger-Lv's space!

评论