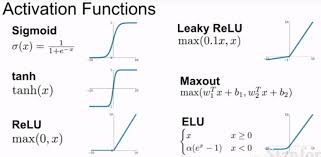

常用激活函数

发表于|更新于|深度学习

|浏览量:

常用激活函数

重点关注ReLU(max(0,x)),Sigmoid(0-1),Softmax(0-1概率)

神经网络之softmax(作用,工作原理【示例说明】,损失计算)_softmax层-CSDN博客

预处理直接做原始图片 (224 * 224 * 3)

文章作者: Roger-Lv

文章链接: http://example.com/2024/09/10/2024-09-10-%E5%B8%B8%E7%94%A8%E6%BF%80%E6%B4%BB%E5%87%BD%E6%95%B0/

版权声明: 本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Roger-Lv's space!

相关推荐

2024-09-10

饱和(saturating)和非饱和(non-saturating)的激活函数

饱和(saturating)和非饱和(non-saturating)的激活函数 在神经网络中,激活函数是决定网络能否学习复杂模式的关键因素之一。激活函数的选择会影响网络的收敛速度、性能以及最终的泛化能力。激活函数可以根据其输出特性被分为“饱和”(saturating)和“非饱和”(non-saturating)两大类: 饱和激活函数(Saturating Activation Functions) 定义: 饱和激活函数是指当输入值增大或减小时,函数的输出值会达到一个上限或下限,并在该范围内趋于稳定,不再随输入的增加而显著变化。 特点: 输出值存在一个明显的上限和下限。 当输入值增大到一定程度后,输出值不再显著增加(或减少)。 例子: Sigmoid 函数:[ \sigma(x) = \frac{1}{1 + e^{-x}} ] Tanh 函数(双曲正切函数):[ \tanh(x) = \frac{2}{1 + e^{-2x}} - 1 ] ReLU 函数(Rectified Linear Unit)在正区间内是非饱和的,但在负区间内是饱和的。 影响: ...

2024-09-05

两万字讲清楚:现在的AI产品有多难做?

两万字讲清楚:现在的AI产品有多难做? https://mp.weixin.qq.com/s/pMt_VMs6uq5wsPPscOyefA 这篇文章深入探讨了AI产品经理在处理大型AI模型时应该考虑的关键问题和机遇。 1. 关注API而非仅仅是产品 核心观点:产品经理应该深入理解大模型的API,因为这是模型能力的直接体现。产品的最终形态往往是API能力的延伸,但可能会因为各种工程限制而与API的能力有所差异。 实际意义:了解API的能力和限制可以帮助产品经理更准确地设计产品功能,避免过度依赖模型无法实现的功能。 2. AI与移动互联网的类比不恰当 核心观点:简单地将AI技术应用到所有应用中并不是一个有效策略。只有那些真正能够从AI中获得显著优势的应用才应该进行AI重构。 实际意义:这要求产品经理进行深入的需求分析和成本效益分析,以确定AI的投入是否真正值得。 3. 产品经理需要学会调用API 核心观点:产品经理应该具备直接与AI模型交互的能力,这有助于更好地理解模型的能力和局限。 实际意义:这种能力可以帮助产品经理在产品开发过程中做出更准确的决策,并能够快速迭代产品以适...

2024-09-05

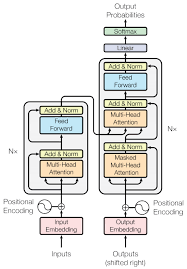

Transformer解析

Transformer解析(Attention Is All You Need) 【超详细】【原理篇&实战篇】一文读懂Transformer-CSDN博客 Transformer论文逐段精读【论文精读】_哔哩哔哩_bilibili 【超详细】【原理篇&实战篇】一文读懂Transformer-CSDN博客 大模型面试准备(十二):深入剖析Transformer - 残差连接和层归一化_残差层和归一化层-CSDN博客 Transformer通俗笔记:从Word2Vec、Seq2Seq逐步理解到GPT、BERT-CSDN博客 “Attention Is All You Need” 是一篇由 Ashish Vaswani 等人撰写的论文,发表于 2017 年的 NeurIPS 会议上。这篇论文提出了 Transformer 模型,Transformer是一种用于自然语言处理(NLP)和其他序列到序列(sequence-to-sequence)任务的深度学习模型架构。Transformer架构引入了自注意力机制(self-attention mechanism),这是一个...

2024-09-05

大模型学习路线

大模型学习路线 现在门槛降低了,成本也降低了。大模型技术爆发,抓住机会。 开源大模型(离线,更安全)/在线大模型 微调:Lora->垂类 适用于用户意图识别 RAG:检索增强生成(一系列专家,提升表现幅度,降低幻觉) 只要提供了正确答案,大概率就不会答错 适合私有数据库 所以依赖于提供的数据库的信息,对数据质量要求比较高 推理更加缓慢(低于微调) 对知识库构建/信息压缩排名等(并非深度学习方面,需要深度学习算法工程师进行辅助) 提示词工程 【AI大模型】Prompt 提示词工程使用详解_大模型prompt的用法详解-CSDN博客 预训练:创造出属于自己的全新大模型 需要算力最多(微调其次,RAG和提示词工程对于算力的要求就没那么高) agent->担任80%脑力工作 一些课程 NLP FudanNLP/nlp-beginner: NLP上手教程 (github.com) 自然语言处理的入门练习 深度学习 跟李沐学AI的个人空间-跟李沐学AI个人主页-哔哩哔哩视频 (bilibili.com) 动手学深度学习 论文精读 https://...

2024-09-10

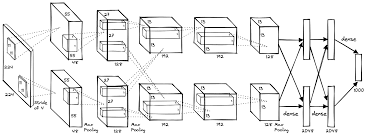

AlexNet解析

AlexNet解析 卷积神经网络经典回顾之AlexNet - 知乎 (zhihu.com) AlexNet论文逐段精读【论文精读】_哔哩哔哩_bilibili 饱和:saturating 非饱和:non-saturating

2024-09-11

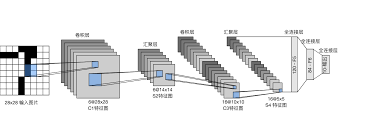

CNN笔记

CNN笔记 CNN笔记:通俗理解卷积神经网络_cnn卷积神经网络-CSDN博客 Zero Padding(零填充)——在卷积神经网络中的作用?-CSDN博客 一句话CNN:如何理解padding的作用和算法 - 知乎 (zhihu.com) 为什么需要随机裁剪:随机裁剪相当于建立每个因子特征与相应类别的权重关系,减弱背景(或噪音)因子的权重,且使模型面对缺失值不敏感,也就可以产生更好的学习效果,增加模型稳定性。

评论

公告

Welcome!